你是否也经历过这样的“AI协作翻车现场”?

满怀期待地把一个GitHub Issue标题,或者一句“帮我重构这个用户模块”,丢给AI Agent。你幻想着半小时后,一个完美的PR会自动呈现在你面前,文档和测试一应俱全。

但现实却是:AI要么压根没理解你的核心需求,要么给了一堆逻辑混乱的代码。最终,你花在给AI纠错、擦屁股上的时间,比自己重写一遍还要长。

几轮折腾下来,你疲惫地靠在椅子上,心里只剩一个念头:“这玩意儿还是不靠谱,最后还得靠自己。”

如果这个场景让你感到无比熟悉,那么恭喜你,踩中了我曾经踩过的同一个坑。

老金我啊,在经历了无数次失败的“AI委派”后,终于想明白一件事:我们带不动AI,问题往往不出在AI身上,而是我们从一开始就犯了三个“管理”上的致命错误。

我们中的大多数人,都掉进了一个“伪委派”的陷阱:我们用“甩锅”的方式,行“委派”之名,却期望AI能像顶级专家一样交付成果。 说实话,用这种方式去带一个真人实习生,他也一样会把你搞崩溃。

带“AI实习生”,和带真人实习生一样,是一门严肃的管理学问。它的成功,不在于AI有多聪明,而在于我们能否为它建立一套清晰、规范的协作流程。

今天,我就把我总结的这套“AI协作三步法”分享给你,它的核心,就是把我们大脑中那些隐性的“高手思维”,显性化为AI能理解的指令,彻底告别低效的“指令式”沟通。

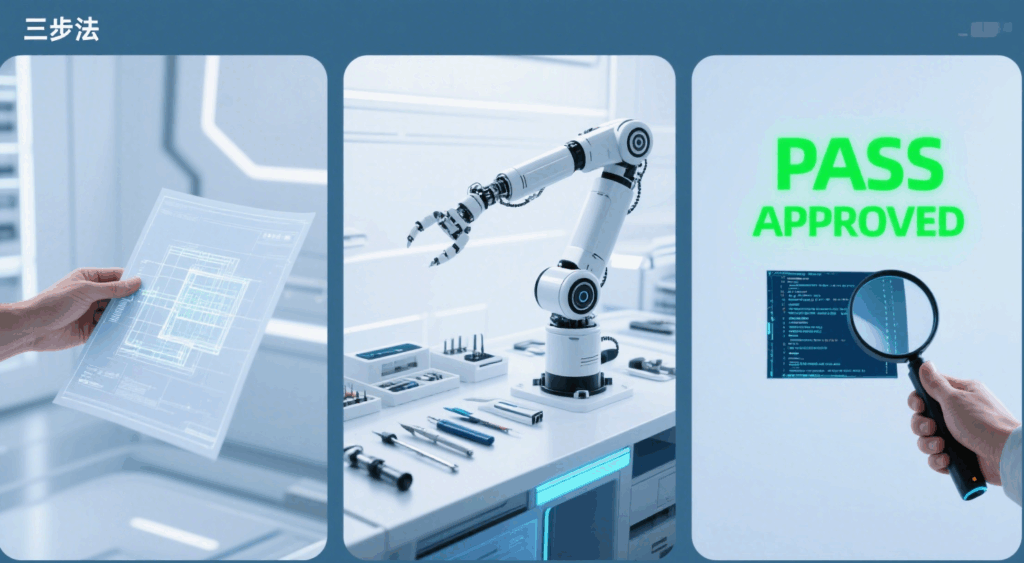

这三个步骤分别是:

- 错误一:给一份“模糊”的任务 -> 解法:编写一份“结构化”的任务简报 (The Briefing)

- 错误二:给一个“毛坯”的环境 -> 解法:提供一个“标准化”的开发环境 (The Environment)

- 错误三:做一次“放水”的验收 -> 解法:执行一次“严格”的代码审查 (The Acceptance)

接下来,我们就一步步拆解,如何把这套方法应用到日常工作中,真正让你手头的AI,从一个“带不动的猪队友”,变成一个“能打硬仗的好帮手”。

AI协作三步法:从“猪队友”到“神助攻”

别把AI当成无所不知的神,把它当成一个有能力、但没经验、极度依赖清晰指令的实习生。成功的关键,就是把我们大脑中那些隐性的“高手思维”,显性化为AI能理解的“流程规范”。

第一步:编写“结构化”的任务简报 (The Briefing) —— 垃圾进,垃圾出

这是最关键,也最容易被忽视的一步。我们常常以为AI能“猜到”我们的想法,但实际上,输入的质量,决定了输出的上限。模糊的指令只会换来模糊的产出。

【错误示范】

# 直接甩锅

"帮我优化下用户登录接口,现在太慢了。"

这个指令,几乎注定会失败。AI不知道“太慢”是多慢,不知道性能瓶颈在哪,不知道关联的系统有哪些,更不知道你的“优化”目标是什么。它只能基于通用知识,做一些不痛不痒的修改,比如改改变量名,或者用上一些看似高级但不治本的语法糖。

【正确姿势】

我们需要像在真实团队中分配任务一样,提供一份结构化的“任务简报”(Briefing)。我通常会用一个Markdown模板来写这个简报,把它贴到Cursor的聊天框,或者写入GitHub Issue的正文里。

这份简报,至少要包含以下几个部分:

1. 背景与动机 (Context & Motivation):

- “我们当前的登录接口 (

/api/v1/login) 平均响应时间在800ms,在晚高峰时期甚至会飙到2s。原因是每次登录都会同步调用三个下游服务进行权限校验,且密码验证使用的是bcrypt,CPU消耗极大。这已经严重影响了用户体验。”

2. 明确目标 (Objectives):

- “本次优化的核心目标是将接口的P95响应时间降低到300ms以下。同时,需要将密码验证算法从bcrypt迁移到Argon2,以降低CPU负载。”

3. 工作范围与约束 (Scope & Constraints):

- “允许修改的文件:

UserController.java,AuthService.java。 - “禁止修改的文件:

UserDAO.java,数据库表结构不允许任何改动。 - “核心依赖: 下游的

PermissionService接口定义不能改变,但你需要将同步调用改为异步消息通知。”

4. 交付物清单 (Deliverables):

- “1. 一个包含所有代码修改的Pull Request。

- “2. 一份更新后的API文档,说明新的调用方式。

- “3. 一个Postman测试脚本,包含成功和失败场景的测试用例。”

你看,当我们把任务定义得如此清晰时,AI就不再是“瞎猜”,而是在一个有明确边界和目标的框架内进行“创作”。这份简报,就是我们为AI画出的“作战地图”。

第二步:提供“标准化”的开发环境 (The Environment) —— 别让你的士兵空手上战场

给完了清晰的任务,我们还得给AI一个“开箱即用”的开发环境。如果AI把大量时间浪费在配置环境、处理依赖冲突、猜测代码风格上,那它的核心创造力就完全被浪费了。

【错误示范】

让AI直接读取你本地一个配置不全、依赖缺失的项目。它可能会因为找不到某个环境变量而胡乱编写代码,或者生成一堆不符合你团队代码风格的代码,你还得在后面逐行修改。

【正确姿势】

我们要为AI提供一个“拎包入住”的标准化环境,让它能把100%的精力都聚焦在“任务简报”上。

1. 对于Cursor:用.cursorrules文件让AI“入乡随俗”

- 在项目根目录下创建一个

.cursorrules文件,这就是你给AI设定的“团队规范”。在这个文件里,你可以用自然语言定义代码风格、注释规范,甚至是Commit信息的格式。 - 示例

.cursorrules:# 编码风格规则 - 所有Python代码必须使用black进行格式化。 - 函数注释必须遵循Google Python Style Guide。 # Git提交规则 - Commit信息必须遵循'feat: '或'fix: '的格式。 - Commit body部分需要简要说明修改原因。 - 有了这个文件,Cursor的AI在生成代码或Commit信息时,就会像一个受过培训的团队成员一样,严格遵守这些约定。

2. 对于Copilot Workspace:用devcontainer实现“一键上岗”

- Copilot Workspace的强大之处在于它能与GitHub Codespaces深度集成。我们要确保项目是“Codespaces-ready”的。

- 在项目里配置好

.devcontainer目录,定义好开发容器所需的所有工具、依赖、环境变量和启动脚本。 - 这样,当Copilot Workspace接到一个Issue开始工作时,它能在一个完全配置好的、确定性的环境中启动,不会因为环境问题走弯路。它需要的所有“武器”(编译器、Linter、测试框架)都已备好,可以直接投入战斗。

第三步:执行“严格”的代码审查 (The Acceptance) —— 你不对代码负责,就要对事故负责

任务完成了,环境也标准了,AI提交了一个PR给你。这时,最危险的时刻到来了。我们很容易因为这是AI生成的代码而放松警惕,简单扫一眼就合并了。这是灾难的开始。

【错误示范】

粗略地看一下代码,逻辑好像没问题,本地跑一下也能运行,然后随手点击“Merge”按钮。结果在线上引发了一个难以追踪的、在高并发下才会出现的Bug。

【正确姿势】

把AI的PR,当成一个非常有才华、但经验为零的初级程序员的首次提交。我们需要用更严格、更系统化的标准去Review它。

1. 自动化验收是底线 (CI/CD)

- 这是最基本的一道防线。你的CI流水线必须足够完备,单元测试、集成测试、静态代码分析、安全扫描,一个都不能少。如果AI的PR连CI都过不了,那就直接打回,让它自己看日志去“反思”。

2. 聚焦于“逻辑正确性”的审查

- AI能保证“语法正确”,但无法保证“业务逻辑正确”。我们的审查重点,必须从代码风格、变量命名这些细枝末节,转移到核心业务逻辑、边界条件处理、以及潜在的性能陷阱上。

- 比如,它写的这段代码,考虑到用户输入为空或超长的情况了吗?它处理并发请求时,加锁了吗?锁的粒度合适吗?这些才是我们资深开发者需要去把关的“命门”。

3. 采用“面试官式Code Review”

- 不要只看不说,或者只留下一句“这里要改”。要像面试一样,在PR的评论里向AI“提问”。

- 示例评论:

- “@Copilot,你在这里选择了用

ArrayList而不是LinkedList,是出于什么考虑?在当前场景下,我们预期的插入和删除操作会很频繁。” - “@Cursor,这个循环里直接调用了数据库查询,当数据量大的时候可能会有性能问题。你有没有考虑过批量查询的方案?”

- “@Copilot,你在这里选择了用

- 这种方式,不仅能逼迫AI(或者说,它背后的模型)给出选择背后的设计思考,暴露它可能没考虑到的地方,更能帮助我们自己,在Review的过程中,把问题思考得更深一层。

总结:从“开发者”到“人机协作架构师”的思维跃迁

遵循这套“AI协作三步法”,你会发现,你和AI的协作效率会发生质的飞跃。你不再是一个跟在后面收拾烂摊子的“保姆”,而是一个运筹帷幄的“项目经理”。

但这背后,揭示了一个更深层次的趋势,我称之为“AI时代的架构师悖论”。

这个悖论是:当AI越来越会“写代码”时,我们作为资深开发者的核心价值,就越来越多地体现在“写代码之外”的能力上。

这些能力,正是我们刚刚在SOP中反复强调的:定义问题的能力、拆解任务的能力、建立标准的能力、管理流程的能力、以及保障最终质量的能力。 这,不就是一名优秀架构师的核心职责吗?

我们花了数年甚至十数年的时间,努力从“写代码”的执行者,进化到“设计系统”的思考者。而现在,为了驾驭AI,我们又必须反过来,将我们大脑中那些抽象的“设计思想”和“架构决策”,重新“编码”成AI能够理解的、精确无误的“流程指令”和“验收标准”。

这看似是一个回归,但实际上是一次螺旋式的上升。

我们正在成为“人机协作混合团队”的架构师。

我们设计的,不再仅仅是软件系统,更是包含了AI Agent在内的高效研发流程本身。我们输出的,不再仅仅是代码,更是能够指导AI进行大规模、高质量创作的“任务简报”和“验收规则”。

所以,下一次当你觉得AI“带不动”时,不妨先问问自己:是我在“管理”上,犯了这三个错误吗?

你是否也为如何给AI“提需求”而苦恼?你认为未来我们还需要哪些新的工具或规范,来更好地管理我们的AI团队成员?

欢迎在评论区聊聊你的看法。

AI代码生成:是解放生产力的“银弹”,还是架构师的“新噩梦”?

当AI能生成“正确”的代码,我们这些35岁+的老程序员,到底“贵”在哪?

AI与代码品味:当机器开始“创作”,我们程序员的价值还剩多少?

文章已同步发布到微信公众号【技术老金】,欢迎关注