一、 开篇破题:我们正在“淹死”在信息里,却“渴死”于没有知识

“老金,快帮我看看,用户服务挂了,是不是跟上次那个订单系统的发布有关?相关的文档和复盘会议纪要在哪?”

上周,我正在集中精力处理一个复杂的性能问题,团队新人小马又一次火急火燎地跑来向我求助。这已经是他这个月第三次问我类似的问题了。我不得不放下手头的工作,在脑海里快速检索那些陈旧的记忆,然后从Confluence上百个页面里,费力地找出那个该死的链接,再把一堆相关的聊天记录截图发给他。

看着小马如获至宝的表情,我却陷入了沉思。这场景,你是不是也似曾相识?

- 新员工的“第一周”:他们满怀激情地加入,却一头扎进了信息的海洋。面对散落在Confluence、GitLab、共享文件夹里的海量文档,他们茫然失措,不知道从何看起,哪个版本是最新,哪个又是已经废弃的“天坑”。

- 老员工的“N次贴”:团队里的资深成员,每天都在回答着相似的“祖传问题”,他们的时间被严重碎片化,变成了行走的“FAQ机器人”,个人的成长和创造力被消磨殆尽。

- 架构师的“黑匣子”:那些至关重要的技术决策、惊心动魄的线上故障复盘、以及在无数次权衡中踩过的坑,都沉睡在某个人的大脑、一封封无人问津的邮件、或者一段段飞速闪过的聊天记录里。它们无法被检索,无法被传承,最终随着人员的流动而烟消云散。

我们花大力气建设了Wiki,购买了昂贵的文档系统,但结果呢?我们只是在机械地“堆砌”信息,而不是在有效地“管理”知识。我们团队的知识,正在以惊人的速度“隐性化”和“流失化”。

这不仅仅是效率问题,这是一个关乎团队核心竞争力的生存问题。

现在,我们不妨设想一下:

如果我们能为团队打造一个“超级大脑”呢?

它能7×24小时在线,能瞬间“阅读”并“理解”我们团队过去十年沉淀下来的所有技术文档、决策历史和最佳实践。无论你是刚入职的新人,还是身经百战的专家,你都可以用最自然的方式向它提问,并在三秒钟内得到精准、可靠、有理有据的回答。

这听起来像是科幻电影里的情节吗?

不,这正是今天要聊的主角——构建团队专属的“领域知识库”与RAG(Retrieval-Augmented Generation)系统。它不是遥远的未来,而是当下我们每个技术团队都触手可及的、能够构建起全新竞争壁垒的强大武器。

二、 深入分析:三步走,构建团队的“知识中枢”

1. 理念升级:从“知识管理”到“知识服务”

在动手之前,我们必须先完成一次关键的理念升级。

传统的知识库,无论是Wiki还是网盘,其核心思想都是**“知识管理”**。它的逻辑是“人找知识”——我们把文档分门别类地存好,然后期待团队成员能像图书管理员一样,在需要的时候精准地找到它。但现实是,这个“仓库”越来越臃肿,信息过载、更新不及时、检索困难,最终沦为“信息的坟场”。

而RAG带来的,是一场关于**“知识服务”的革命。它的逻辑是“知识找人”**。我们不再需要关心知识具体存在哪个页面的哪个角落,我们只需要提出问题,系统就会主动、智能地将最相关的知识“喂”到我们嘴边。

我喜欢用一个比喻来解释RAG的魔力:

RAG = 一个聪明的大脑 (LLM) + 一座专属的图书馆 (领域知识库)

LLM就像一个天赋异禀但涉世未深的“天才少年”,他懂天下事,但唯独不懂我们公司的业务和技术细节。而我们的领域知识库,就是专门为他打造的、包含公司所有“内功心法”的“藏经阁”。RAG的作用,就是教会这个天才少年,在回答我们内部问题之前,先去藏经阁里查阅最相关的资料,然后基于这些资料,给出精准、可靠的回答。

这个“查阅->思考->回答”的过程,就是我们构建RAG系统的核心。

2. 实战构建:从0到1打造你的RAG系统

理论说清了,我们直接上干货。构建一个基础的RAG系统,拢共分三步。

第一步:知识源的“收”与“洗”(构建高质量语料库)

这是整个系统中最重要,也最容易被忽视的一步。记住,Garbage in, garbage out。语料库的质量,直接决定了最终“大脑”的智商上限。

- “收”(Ingestion):这一步的目标是“应收尽收”。我们需要编写脚本,将散落在各处的非结构化和半结构化知识源,自动化地汇集起来。常见的知识源包括:

- Confluence/Wiki: 可以通过API批量导出页面。

- Git仓库: 主要是代码库中的

.md文档。 - 共享文件: 如PDF格式的技术白皮书、Word格式的需求文档等。

- (进阶)聊天记录: 如Slack、Teams中的公开技术频道,这里面有大量即时的Q&A和决策过程。

- “洗”(ETL):原始文档是无法直接喂给LLM的。我们需要对它们进行清洗和预处理。

- 智能分块(Chunking): LLM的输入窗口(Context Window)是有限的,我们不可能把一篇几万字的文档一次性丢给它。因此,必须将长文档切分成更小的、语义完整的“知识块”。

- 为什么重要? 分块的大小直接影响检索的精度和最终答案的质量。太大的块会包含太多噪声,太小的块又可能丢失上下文。

- 常用策略:可以按章节、段落、或者固定字符数(比如每500个字符切一块,并保留100个字符的重叠部分

overlap以维持上下文)。对于Markdown这样有明确结构化语法的文档,按标题等级(H1, H2)进行切分是更好的选择。

- 添加元数据(Metadata):这是专业玩家和普通玩家拉开差距的关键。我们需要为每一个知识块,打上尽可能丰富的“标签”。

- 有什么用? 元数据可以让我们在检索时进行更精准的“过滤”。比如,我只想在“订单系统”这个项目的,“架构设计”分类下,由“老金”创建的文档里寻找答案。

- 常见元数据:

{ "source": "confluence-page-123", "author": "laojin", "project": "order-system", "category": "architecture-design", "created_at": "2024-10-01" }

- 智能分块(Chunking): LLM的输入窗口(Context Window)是有限的,我们不可能把一篇几万字的文档一次性丢给它。因此,必须将长文档切分成更小的、语义完整的“知识块”。

第二步:知识的“存”与“搜”(选择合适的向量数据库)

经过“收”和“洗”,我们得到了一堆干净的知识块。现在,需要把它们变成机器能理解的语言,并高效地存储起来。

- 核心概念:Embedding(向量化)

- 你可以把它简单理解成一个“语义压缩”的过程。Embedding模型(如OpenAI的

text-embedding-3-small)会将每一个知识块,都转换成一个由几百上千个数字组成的“向量”。 - 关键特性:在向量空间里,语义上越相似的文本,它们的向量“距离”就越近。比如,“如何部署用户服务”和“用户服务的发布流程”这两个句子的向量,会比它们和“食堂下周菜单”的向量要近得多。

- 你可以把它简单理解成一个“语义压缩”的过程。Embedding模型(如OpenAI的

- 技术选型:向量数据库

- 向量数据库就是专门用来存储和高效检索这些“向量”的。当用户提问时,我们先把问题也变成一个向量,然后去数据库里寻找“距离”最近的N个知识块向量。

- 快速选型指南:

- 轻量级/入门:

ChromaDB,FAISS。它们可以作为库直接在你的代码里运行,无需单独部署,非常适合快速验证和中小型项目。对于大部分团队来说,从ChromaDB开始,是成本最低、见效最快的路径。 - 生产级/大规模:

Pinecone,Weaviate,Milvus。它们是独立的、功能更强大的数据库服务,支持分布式、高并发和更复杂的过滤查询。

- 轻量级/入门:

第三步:知识的“问”与“答”(搭建RAG查询链路)

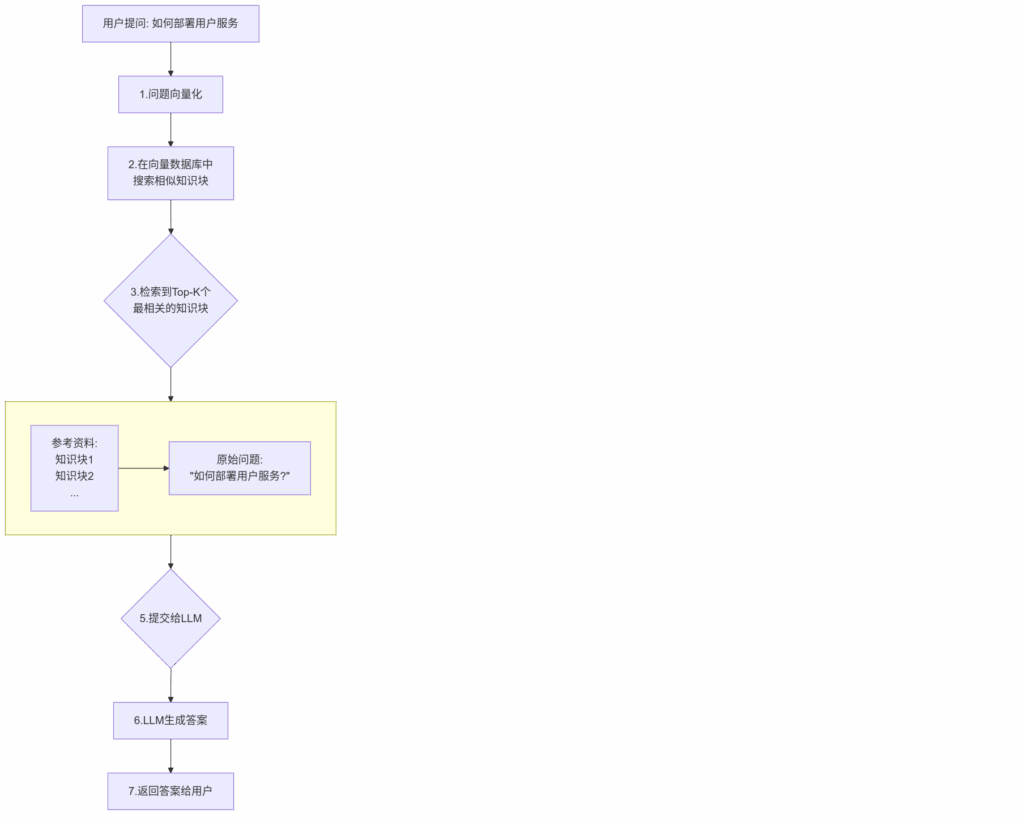

万事俱备,我们来搭建最后的查询链路。下面这张图,就是RAG系统的核心工作流程。

- 拆解关键节点:

- 检索(Retrieval):从数据库中捞取最相关的知识块。除了最简单的Top-K(返回最相似的K个),还可以设置一个“相似度阈值”,低于这个分数的块就不要了,避免引入不相关的噪声。

- 增强(Augmentation):这是决定LLM回答质量的“魔法”所在。我们需要构建一个高质量的Prompt,本质上是在给LLM下达一个明确的指令。一个典型的Prompt结构如下:

### System Prompt (系统指令) 你是一个资深的AI技术助手。请严格根据下面提供的“参考资料”来回答用户的问题。 - 你的回答必须简洁、清晰、有条理。 - 如果“参考资料”中没有足够的信息来回答问题,请明确告知用户“根据现有资料,我无法回答这个问题”,禁止编造答案。 ### 参考资料 --- [这里插入从向量数据库中检索到的知识块1] --- [这里插入知识块2] --- ... ### 用户问题 [这里插入用户的原始问题]

这个Prompt通过清晰的指令和边界设定,有效地“约束”了LLM,强迫它“戴着镣铐跳舞”,从而极大地提升了答案的准确性和可靠性。

三、 总结升华:超越技术,RAG成功的三个关键

走到这里,你已经掌握了构建一个RAG系统的全套“武功招式”。但这套武功最终能发挥多大威力,往往取决于“心法”。一个RAG系统最终是成为团队的“新护城河”,还是沦为又一个无人问津的“玩具”,技术本身往往不是决定性因素。

根据我的经验,以下三点“心法”更为关键:

1. 文化大于技术

RAG系统不是“银弹”。一个最先进的RAG系统,如果面对的是一个空空如也、或者充斥着大量过时信息的知识库,那它也毫无价值。

真正的挑战在于,如何建立一个正向的、可持续的知识贡献和更新文化?

- 降低贡献门槛:让文档的编写和更新,像写一条Commit Message一样简单自然。

- 建立正向激励:公开表彰那些高质量知识的贡献者,让他们的智慧和付出被所有人看见。

- 拥抱“文档即代码”:将核心技术文档纳入代码仓库进行版本管理(Docs-as-Code),通过Pull Request来评审和更新文档,让知识的迭代和代码的演进保持同步。

记住,RAG系统是“果”,而一个活的、持续生长的知识库才是“因”。没有好的“因”,结不出甜的“果”。

2. 运营大于建设

系统上线,掌声响起,但这仅仅是长征的第一步。

一个RAG系统最宝贵的资产,不是它的代码,而是用户与它交互时产生的海量数据——尤其是那些用户不满意的“Bad Case”。

- “我问A,它为什么给了我B的答案?”

- “这个问题很基础,为什么它会说资料不足?”

每一个“Bad Case”,都是一个指向知识库盲区或RAG系统弱点的“路标”。我们需要建立一套持续运营的机制,定期分析这些失败案例,然后反向去优化我们的知识库:

- 是知识缺失了?那就补充上。

- 是知识过时了?那就去更新。

- 是文档分块不合理,导致检索时上下文丢失了?那就调整Chunking策略。

一个“建完不管”的RAG系统,生命周期不会超过三个月。只有通过持续的运营和迭代,它才能真正地“成长”起来,变得越来越聪明。

3. 始于AI,终于人

最后,我们必须回归初心。我们为什么要构建RAG?

它的终极目标,不是为了取代任何人的工作,更不是为了取代团队成员的思考。恰恰相反,它是为了将我们从那些重复、繁琐、低价值的“信息检索”和“知识搬运”工作中解放出来。

它应该成为团队能力的“放大器”,而不是“替代品”。

- 它让新员工能更快地融入团队,独立解决问题。

- 它让资深专家能从重复的答疑中抽身,聚焦于更具挑战性的创新。

- 它让整个团队的智慧得以沉淀和传承,在人员流动中保持强大的韧性。

一个成功的RAG系统,最终会融入团队的血液,成为基础设施的一部分。它静默地工作,却有力地支撑着每一个人,让知识的流动如呼吸般顺畅自然。

结尾

从信息的“沼泽”到知识的“源泉”,RAG为我们架起了一座坚实的桥梁。构建团队专属的知识库,已经不再是一个“加分项”,而是AI时代下,技术团队构筑核心竞争力的“必选项”。

它不仅是技术的革新,更是一场关乎团队协作模式和知识文化的深刻变革。

希望今天的分享,能为你和你的团队,提供一张清晰的行动路线图。

最后,留一个开放性问题:你的团队正在被哪些“知识孤岛”问题所困扰?你认为RAG还能为团队带来哪些意想不到的价值?

欢迎在评论区分享你的看法,我们一起探讨。

觉得这篇文章对你有启发,别忘了点赞、关注,让更多需要的人看到它。

技术老金 同步发布至微信公众号【技术老金】,欢迎关注

技术老金 同步发布至微信公众号【技术老金】,欢迎关注