最近我带的一个AI项目,月底复盘成本时,团队所有人都被账单吓了一跳。一个看似简单的文档智能问答功能,模型API的调用费用,竟然占了整个项目云资源的近70%!老板的脸当时就绿了,开玩笑说:“再这么下去,我们不是在做AI,是在给模型公司‘印钞’。”

这虽然是个玩笑,但却揭示了一个残酷的现实:我们享受着大模型带来的强大能力,却也必须直面它高昂的推理成本。这就像你拥有了一台法拉利,驾驶体验无与伦比,但每次去加油站心都在滴血。

作为架构师,我们的价值不仅仅是实现功能,更在于做出明智的权衡。在一个技术爆炸、人人都在给系统做“加法”的时代,如何为AI应用的成本和性能找到那个微妙的平衡点,恰恰是我们必须修炼的核心内功。

今天,老金我就和大家聊聊,我们如何在成本与性能之间走钢丝,设计出高性价比的LLM应用架构。

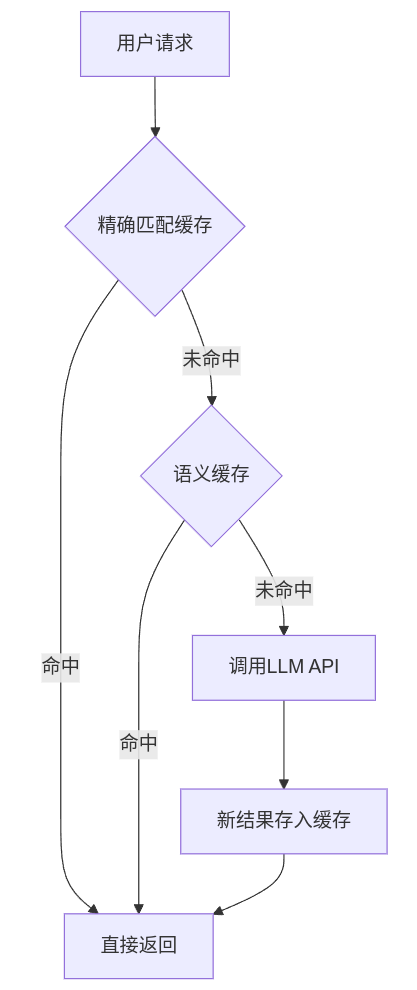

策略一:模型缓存 (Caching) – 最容易想到的“节流阀”

这是最直观的降本策略。当一个问题被问过一次后,我们就把答案存起来,下次再有人问同样的问题,直接返回缓存的答案,就不用再去调用昂贵的模型了。

这就像我们去图书馆借书,聪明的管理员会把最近最热门的书放在前台的“热门借阅区”,下次有人来借,他一眼就能看到,直接递给你,而不用每次都跑到几万册藏书的书库深处去寻找。这个“热门借阅区”就是缓存。

在LLM应用中,缓存可以分为两个层次:

- 精确匹配缓存 (Exact Match Caching): 对用户的输入(Prompt)进行哈希计算,如果哈希值完全相同,就返回缓存的答案。这对于知识库问答、FAQ等场景非常有效,因为很多问题是高频重复的。

- 语义缓存 (Semantic Caching): 用户的提问千奇百怪,但意思可能一样。比如“如何申请报销?”和“报销流程是怎样的?”。语义缓存通过将用户问题转换为向量,在向量空间中寻找“语义相似”的已缓存问题。如果相似度超过某个阈值,就返回对应的答案。

架构师的权衡:

- 优点: 实现简单,立竿见影。对于高频、重复性强的查询场景,成本优化效果极佳。

- 缺点: 对于动态、个性化强的场景(如自由对话),缓存命中率很低。语义缓存本身需要进行向量计算,会引入额外的延迟和计算开销,需要评估其ROI。

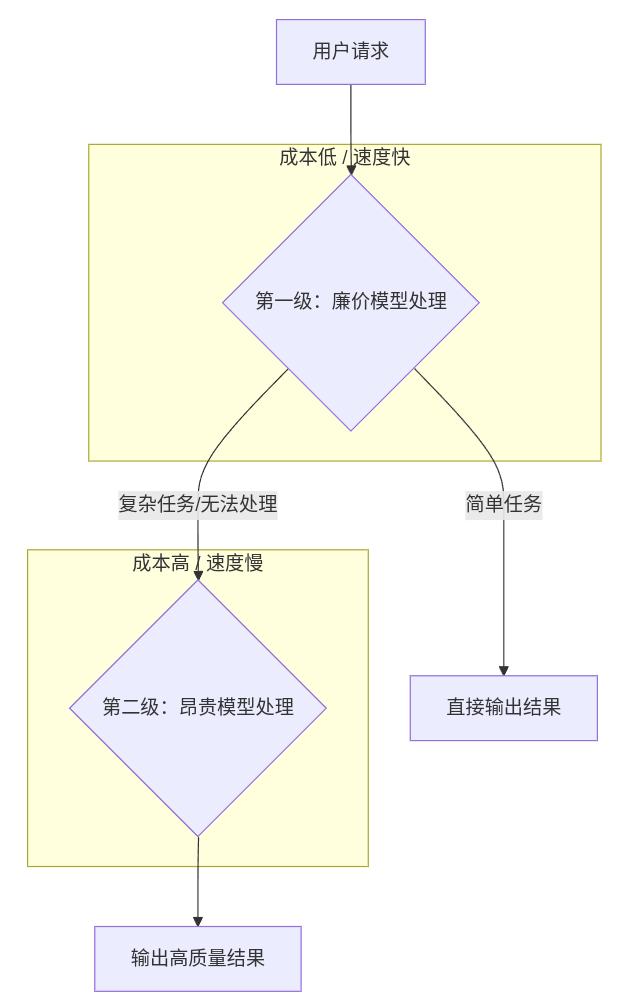

策略二:模型级联 (Cascading) – 好钢用在刀刃上

这是我个人最推崇的架构模式,因为它最能体现架构师“资源优化”的智慧,也是我们在《AI-Native架构设计》中提到的“动态编排”思想的简化落地。核心思想是:用廉价、快速的模型处理绝大多数简单任务,只有当它们无法解决时,再“升级”到昂贵、强大的模型。

这就像一个大型医院的分诊体系。你感冒发烧,肯定是先去社区医院或者门诊部,让普通医生给你看看。只有当普通医生判断你的病情复杂,他才会建议你转诊到三甲医院,挂一个昂贵的专家号。我们绝不能让顶级的医学专家去处理每一个头疼脑热的病人,那会造成巨大的资源浪费。

在LLM应用中,我们可以设计一个类似的分诊流程:

一个典型的级联策略:

- 第一级 (守门员): 使用一个轻量级的开源模型(如Llama-3-8B)或一个廉价的API(如GPT-3.5-Turbo、Claude 3 Haiku)。它负责判断用户意图、回答简单事实性问题。

- 第二级 (专家): 如果第一级模型认为问题超出了它的能力范围(例如,需要复杂的逻辑推理、代码生成或深度内容创作),它就会将请求“转诊”给GPT-4或Claude 3 Opus这样的顶级模型。

架构师的权衡:

- 优点: 在保证绝大多数用户体验的同时,能将成本控制在极低的水平。据统计,80%的请求都可以被廉价模型满足。

- 缺点: 设计复杂度更高,需要定义清晰的“转诊”规则(Routing Logic)。这个规则本身可能就需要一个模型或一套复杂的逻辑来判断,增加了系统的维护成本。

- 如何实现“转诊”? 思路有多种:可以基于关键词和规则(如包含“代码”、“分析”等词就转给专家模型);也可以让第一级模型自己判断任务复杂度,输出一个“需要转诊”的标识;甚至可以训练一个专门的、极轻量的分类模型来做“分诊台”。

策略三:请求合并/批处理 (Batching) – “拼单”的智慧

很多时候,我们的应用需要处理大量非实时的请求,比如批量分析用户评论、总结文章摘要等。这时,如果来一个请求就调用一次API,效率极低。

请求批处理的逻辑很简单:攒一波,再处理。

这就像我们点外卖,一个人点要付一份配送费,但如果整个办公室的人一起点,大家平摊配送费就便宜多了。批处理就是通过“拼单”,摊薄了每次API调用的固定开销和网络延迟。

架构师的权衡:

- 优点: 显著提升吞吐量,降低单位请求的成本。非常适合离线分析、数据清洗等后台任务。

- 缺点: 最大的代价是牺牲了实时性。因为每个请求都必须等待“拼单”完成,导致单个请求的延迟显著增加。因此,它完全不适用于需要即时反馈的场景,如在线聊天机器人。

策略四:本地化部署 (On-Premise) – 把“印钞机”搬回家

当成本、数据隐私或网络延迟成为首要考虑因素时,把开源大模型部署在自己的服务器上,就成了一个极具吸引力的选项。

这相当于你不再去法拉利4S店租车,而是花钱买了一台(或许性能稍弱,但完全够用的)家用车。初始投入很高,但后续的“油费”(电力和维护)就完全由自己控制了。

架构师的权衡:

- 优点:

- 成本可控: 一次性硬件投入后,推理成本只与电费和运维相关,调用次数不受限制。

- 数据安全: 所有数据都在自己的私有环境内,完美解决数据隐私和合规问题。

- 低延迟: 免去了公网API调用的网络开销,响应速度更快。

- 缺点:

- 技术门槛高: 需要一个专业的团队来负责模型的部署、优化、监控和维护,这是一笔巨大的技术和人力成本。

- 硬件投入大: 高性能的GPU服务器价格不菲。

- 模型能力局限: 开源模型的能力通常与顶级的商业闭源模型(如GPT-4)仍有差距。

策略五:为Token瘦身 (Token Dieting) – 精打细算过日子

如果说前面四种是宏观的架构策略,那这一种就是深入到每一次API调用的“微操”省钱技巧。大模型的计费单位是Token,我们发的Prompt和它返回的Completion,每一片纸都是钱。

这就好比打包行李,箱子空间有限(上下文窗口),每件行李都要花托运费(Token成本)。聪明的旅行者会选择轻便、多功能的物品,而不是把整个衣柜都塞进去。

为Token瘦身主要有两个方向:

- Prompt压缩 (Input Dieting):

- 精简指令: 用更短、更精确的词语。比如用“Be concise”代替“Please try to be as brief as possible in your response”。

- 减少样本: 在Few-shot场景中,减少示例的数量,或将示例压缩。

- 上下文管理: 对于多轮对话,不是把全部历史记录都发过去,而是只发送最近的几轮,或者让一个廉价模型先把历史记录“总结”一下再发过去。

- 结构化输出 (Output Dieting):

- 指定格式: 要求模型返回JSON或其他紧凑格式,而不是大段的自然语言描述。这不仅能减少返回的Token数,还方便程序解析。

- 限制长度: 明确告知模型最大输出长度。

架构师的权衡:

- 优点: 实现简单,几乎没有额外的架构成本,能直接降低单次调用的费用。

- 缺点: 过度压缩Prompt可能会导致模型理解偏差,影响输出质量。需要反复调试,找到“效果”和“成本”的最佳平衡点。

总结:没有银弹,只有一张决策地图

我们今天讨论了缓存、级联、批处理、本地化部署和Token瘦身这五种核心的降本增效策略。你会发现,没有一种策略是完美的“银弹”,每一种都在用某方面的牺牲(如延迟、复杂度、初始投入)去换取成本的降低。

为了让你能更直观地进行决策,我把这五大策略的核心权衡点总结成了一张地图:

| 策略名称 | 核心思想 | 成本节约潜力 | 实现复杂度 | 延迟影响 | 最佳适用场景 |

|---|---|---|---|---|---|

| 模型缓存 | 存下问过的答案 | 高 | 低 | 降低 | 高频重复的问答、FAQ |

| 模型级联 | 先用便宜的,不行再用贵的 | 极高 | 高 | 可能略增 | 任务复杂度差异大的混合场景 |

| 请求批处理 | 攒一波,一起处理 | 中 | 中 | 显著增加 | 离线分析、后台批量任务 |

| 本地化部署 | 把模型搬回家 | 长期高,短期负 | 极高 | 降低 | 数据隐私要求高、调用量巨大 |

| Token瘦身 | 精简输入和输出 | 中 | 低 | 无 | 所有API调用场景 |

这恰恰回归了架构师的本质工作:取舍(Trade-off)。

我们的职责,不是盲目地追求最强大的模型、最酷的技术,而是在深刻理解业务场景和限制条件(预算、隐私、性能要求)的前提下,像一位精明的指挥官,将有限的资源配置在最关键的地方,设计出那个“恰到好处”的系统。

这呼应了我们在AI给了我们无限可能,但架构师的职责是做“减法”中探讨的理念。在AI时代,当人人都在做加法时,懂得如何理性地做“减法”,如何做出更高明的“取舍”,正是我们这些老家伙的核心价值所在。

关于LLM应用的成本优化,你还有哪些独门秘籍?欢迎在评论区分享你的看法,我们一起交流。

觉得这篇文章对你有帮助?别忘了点赞、推荐,并分享给需要的朋友。你的支持是我持续创作的最大动力!也欢迎关注我的公众号『技术老金』,获取更多AI时代的架构师实战经验。

技术老金 同步发布至微信公众号【技术老金】,欢迎关注

技术老金 同步发布至微信公众号【技术老金】,欢迎关注